본 글은 Yutube Google 공식 홈페이지에서 제공하는 영상을 기준으로 작성하였습니다.

본 글의 이미지에 대한 모든 저작권은 구글에 있으며, 직접 영상을 보고 캡쳐하여 작성하였습니다.

Link : https://www.youtube.com/watch?v=cNfINi5CNbY

최근 ChatGPT와 MS의 공세에 코드레드를 발령하고 긴급하게 돌아간다던 구글이 Keynote Speech를 했습니다.

ChatGPT를 견제한 탓인지, 선다피차이 Introduction이 10여분 수준임에도141번 'AI'라는 단어를 언급했다는 밈이 돌아다니고 있습니다.

그정도로 AI에서 시작해서 AI로 끝난 컨퍼런스였습니다.

인상깊었던 키워드들 기준으로 빠르게 요약해보겠습니다!

Keynote Contents - Introduction

1. Immersive View

카카오/네이버/구글에서 제공하던 로드뷰(Road View)는 정적인 이미지로, 뚝뚝 끊어지는듯이 지도가 보입니다.

당연히 실시간 교통상황 반영은 안되구요, 직접 차가 돌며 찍었던 사진들을 조합해서 제공하는 서비스에 불가했습니다.

하지만, 금번 구글이 제공하는 "Immersive View"는 Bird eyes View처럼 마치 위에서 아래로 내려다보는듯한 관점에서 나무하나하나, 교통도 현 시점의 상황에맞게 차량들이 움직입니다.

해당 지역에서 비가 오면 하기와 같이 스크린에 실제로 비가 그려지구요

즉, 더이상 단순한 이미지 조합의 로드뷰나 지도가 아니라 해당 지역의 모든 현실 상황을 반영하는 고정밀 시뮬레이션 지도가 제공될 예정입니다. 올해 말부터 15개 도시만 선공개된다고 하는데 한국은 미포함인듯합니다.

이 기술에서 제가 느끼는 비전은 "VR/AR"입니다. Immersive View와 같이 현실 상황을 아주 정확하게 모사해내는 환경에 VR 고글을 쓰고 접속하면 어떻게될까요?

구글 글래스와 같이 구글도 VR/AR 개발의 끊을 놓지않고 있는데, 머지않은 미래에 메타버스/AR,VR/Immersive View의 조합을 통해 이런식으로 응용이 가능할수도 있을것 같습니다.

2. PaLM2

2-1) PaLM2 모델 개발 및 BARD 적용

PaLM2는 OpenAI의 ChatGPT 시리즈 처럼, 구글이 만들고 있는 LLM(Large Language Model)입니다.

저는 기술 Follow up, 트렌드 비교를 위해 ChatGPT +(유료버전)과 BARD(구글 LLM AI 공식 명칭) 모두 쓰는데요

현재까지의 BARD는 ChatGPT에 비해 성능이 많이 떨어졌습니다.

제가 개인적으로 체감하기에는 ChatGPT3.0정도 되지 않을까 생각되는데요, 그랬던 이유가 이제까지의 BARD에 적용된 LLM 모델이 "LaMDA"라는 구버전 모델이였기 때문입니다.

향후 BARD의 AI모델을 PaLM2로 갈아끼우면서, 성능을 비약적으로 끌어올리며 Multi Modal 기능도 함께 탑재예정이라고 합니다.

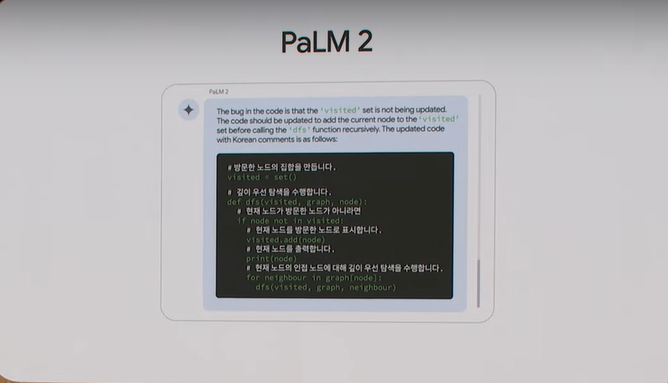

그리고 이건 약간 국뽕?인데, PaLM2를 시연할때, Korean으로 코드를 해석해달라고 명령을 하는 장면이 나옵니다.

PaLM2가 초기에 제공하는 언어는 전세계에 단 3개로, "일본어", "영어", "한국어" 입니다.

개인적으로는 조금 정치적인 의도가 있다고 생각되었는데요. 삼성의 모든 노트북은 MS(MicroSoft) Window를 사용하기 때문에 AI에서 주도권을 빼앗기게되면, OS(Operating System,운영체제) 주도권이 구글에서 MS로도 넘어갈수있지않을까라고 생각하여 "우리도 AI 경쟁력 충분하고, 건재하다" 라는 것을 어필하기 위함이 아니었나 생각됩니다.

BARD에도 I/O이후 곧 바로 적용된다고했는데, 아직까지는 적용이 안된것같습니다.

당사자한테 직접물어보니 그렇다고하네요.

2-2) Med-PaLM

Google I/O 발표 후, 구글의 주가가 급등한 가장 큰 원인 중 하나가 아닐까 생각됩니다.

PaLM이라는 거대한 인공지능 모델을, Med(Medical, 의학)에 Fine-Tuning하여 만들어낸 기술입니다.

구글의 발표에 따르면 하기와 같이 2023년 이전 모델들 대비, Med-PaLM은 의학 시험에서 Expert이상의 퍼포먼스를 보여주었다고합니다. (ChatGPT를 견제하는것 같네요)

이것에 대한 시연으로는 하기와 같이, X-ray 사진을 입력으로(Multi-Modal이 된다는 간접적 표출)하고, 나의 상태가 어떤지 묻습니다. 이에 대해 Med-PaLM2는 아주 자세한 분석결과를 텍스트로 내놓습니다.

의사가 100%사라질꺼라고 생각하진 않습니다. 다만, 100명의 의사가 필요하던 일을 10명이 할수도있지않을까라는 생각이 드는것도 사실입니다. 예를들어, 현재 식당에선 키오스크/로봇의 활용으로 주방인력위주로 인원을 구성하면 되죠.

의사도 직접 의사가 상담하고 진료를 보기보단 수술을 집도하는 의사(이것도 요즘은 로봇과 함께 협력)들이 조금 더 경쟁력이 있지않을까 생각됩니다.

구글의 주가가 급등한 이유중 하나로 많은 전문가들이 Med-PaLM2를 꼽습니다.

저도 그렇게 생각하는데요, Med-PaLM2를 사용한다면 영상통화/원격 진료? 이런 분야들은 더이상 의미가 없어지겠죠..

IBM의 Watson도 그렇고, 의학은 생명과 직접적으로 관련되어있기에 모든 기업들이 다소 기술이있더라도 공개하기를 꺼려헀는데요, 구글이 이렇게 공식적으로 도전장을 던진다는것은 기술적으로는 충분히 검토가 되지않았나 생각됩니다.

3. 생성형 AI 기반 사진 편집 기술

카메라 편집에 있어, 생성형 AI가 가장 혁신적인 일을 해낼것이라 생각했었는데요, 그것이 현실로 일어났습니다.

아래 두개의 그림을 편집전/후로 나누어놓았습니다.

보시면 편집전 대비 배경은 그대로 두고, 인물의 위치를 오른쪽으로 옮겼는데요

뒷 배경에 전혀 이질감 없이 편집이 된 것을 확인할 수 있습니다.

이게 무슨 기술이냐면, 편집 전의 사진만 볼때는 인물의 몸에 가려진 뒷부분은 전혀 유추할수가 없습니다.

예를들어 인물의 머리 뒤에 가려진 숲/바위 같은 것들은 전혀 알수가 없는 상황이죠

하지만 생성형 AI를 통해 인물에 의해 가려진 뒷부분들을 AI가 모두 상상해내고 알아서 편집 해준다는 점이 큰 인사이트입니다. 아래 이미지에서 보시다시피 이렇게 편집된 이미지가 전혀 이질감이 없음을 확인할 수 있습니다.

4. AI 윤리

Stable Diffusion같은 생성형 AI를 통한 이미지 생성이 활발하게 일어나고 있습니다.

기술적으로는 진일보하여 좋아보이나, DeepFake/가짜뉴스 같은 문제들도 발생하고 있죠

https://techrecipe.co.kr/posts/42069

일론 머스크가 암호화폐 투자 홍보하는 딥페이크 영상 - 테크레시피

테슬라와 스페이스X CEO인 일론 머스크가 가짜 암호화폐 거래소 투자를 홍보하는 내용을 담은 딥페이크 영상이 발견됐다. 이 영상은 사기 그룹이 탈취한 유튜브 채널을 통해 게재하고 있다고 보

techrecipe.co.kr

이런 AI를 활용하는 부분들에 있어, 윤리적인 부분들을 케어하고자 구글은 노력하고 있다고 어필합니다.

그 중 하나로, 구글의 AI를 통해 생성한 모델들은 내부적인 "Water Mark"를 추가하여 인터넷에 떠돌아 다닐때 이것이 생성된 이미지인지 실제 사진인지를 분간할 수 있는 표식을 만들었다고합니다.

취지는 좋으나, 워터마크가 있다는게 세상에 밝혀지는 순간 이걸 지우려고 하는 엔지니어들도 생기게 될것입니다.

구글이 어떤식으로 워터마크를 남겨 다른 엔지니어들이 범접할 수 없게끔 해놓았는지 궁금합니다.

Keynote Contents - Engineering

위의 내용들은 선다 핏차이가 발표한, 초반 20분 Introduction에 관해 정리한 내용입니다.

이번 섹터에서는 개발진들이 직접 나와서 발표한 내용들에 대해 다루어보겠습니다.

전혀 새로운건 아니고, 선다 핏차이가 발표한 내용들을 조금 더 깊게 말하는 장이였다고 보시면 됩니다.

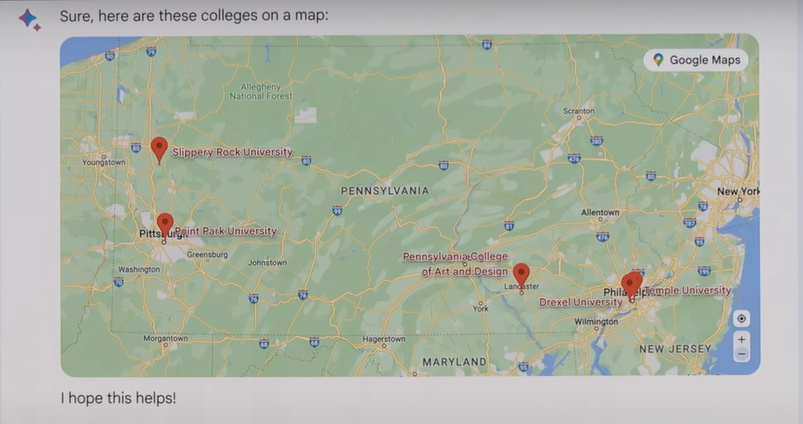

1. Google Map-BARD 연동/강력한 파트너쉽 과시

ChatGPT와 달리 구글이 경쟁력을 가질 수 있는 부분입니다.

MS를 등에 엎고있다곤 하나, ChatGPT의 Extension 목록을 보면 여전히 여러회사들과의 협업을 추진하는것 처럼 보입니다.

하지만, 구글은 이미 내부 인프라만으로도 충분한 Extension을 가지고 있기에 바로바로 적용하는 모습을 보입니다.

기술 시연에서는, 본인 집 주변에서 가깝고 좋은 대학교를 가고싶다는 질문에 하기와 같이 Google Map을 연동하여 위치를 찍어줄 뿐 아니라, Table형식으로 학교 소개까지 정리해주는것을 볼 수 있습니다.

이 부분은 구글맵을 연동할수있다라는 내용보다는, 조금 더 거시적으로 "우리는 BARD만 완성되면 구글이 가지고있는 모든 제품과 연결할수있다." 라는 어필로 보입니다.

그 이유로, 위의 시연이 끝나고 바로 협업하는 회사들이 쭉 소개되는데요, OpenAI가 기죽을만큼 List-up이 화려합니다.

"우리는 이만큼 경쟁력이 있고, 강력한 협업 파트너들이 있다."라고 OpenAI에 경고를 하는듯 합니다.

위에서도 한번 언급했지만, 국뽕으로 "일본어", "한국어", "영어" 3개 언어부터 BARD를 선지원한다고합니다.

마치 "삼성! 보고있어? 딴생각 하지마, Android/Chrome에도 이기능 다 넣어줄테니까" 라고 말하는 것 처럼 느껴지네요

.Google I/O 2023 초반부 (AI~BARD)를 강조하는 부분을 위주로 정리해보았습니다.

2시간이상 분량의 컨퍼런스였던 관계로, 2편에 나누어서 글을 정리해볼까합니다.

다음 글은, AI가 아닌 직접적으로 고객이 느낄수 있는 변화 위주로 정리해보겠습니다.(H/W, 구글 폴더블폰, 클라우드, 안드로이드)

긴글 읽어주셔서 감사합니다.

[다음 글]

https://limitsinx.tistory.com/270

[IT] Google I/O 2023 요약 정리 - 2 (Workspace, Pixel Fold, 클라우드, 안드로이드)

본 글은 Yutube Google 공식 홈페이지에서 제공하는 영상을 기준으로 작성하였습니다. 본 글의 이미지에 대한 모든 저작권은 구글에 있으며, 직접 영상을 보고 캡쳐하여 작성하였습니다. Link : https:/

limitsinx.tistory.com

'New Tech Trend' 카테고리의 다른 글

| [LLM] ChatGPT/Cluade/Wrtn 비교 사용 후기 (39) | 2024.05.17 |

|---|---|

| [IT] Google I/O 2023 요약 정리 - 2 (Workspace, Pixel Fold, 클라우드, 안드로이드) (2) | 2023.06.06 |

| [전기차] NIO-DAY 정리 (0) | 2021.11.20 |

| [재미로 읽는 공학-4] OTA(Over The Air)란 ? (2) | 2020.12.28 |

| [재미로 읽는 공학-3] 화웨이의 '백도어(Back door)'란 무엇인가? (3) | 2020.12.10 |

댓글