[논문 전문] : https://arxiv.org/abs/1612.02136

[출처] https://doi.org/10.48550/arXiv.1612.02136

※ The picture and content of this article are from the original paper.

All picture and figures used in this article are sourced from publicily available on the internet.

[논문 요약]

Mode Regularized Generative Adversarial Networks

MR-GAN은 GAN 초창기에 Mode Collapse 문제를 해결하고자 Mode Seeking GAN과 같이 노이즈와 생성결과물에 대한 명시적인 Loss Term을 추가한 논문입니다.

아마 이때즈음부터 GAN에 AE(Auto Encoder)를 연동하여 새로운 Loss들을 개발하는 연구들이 많이 발표되었던것 같습니다.

개인적으로는 그렇게 선호하는 방식은 아니지만(MR-GAN보다 Mode Seeking GAN이 낫다고 생각) citation도 높고 당시 많이 활용된 기술이라 한번 정리해보고자 합니다.

Contents

기존 GAN대비 MR-GAN의 Novelty는 크게 3가지로 나누어집니다.

1. Geometric Metrics Regularizer

2. Mode Regularizer

3. Manifold-Diffusion Training for Regularized GANs

이름은 거창한데 정말 별거 없습니다. 옛날 논문이라.. 그당시에는 이름을 그냥 자기 짓고싶은대로 지었구나 생각하시면 됩니다.

1. Geometric Metrics Regularizer

AutoEncoder의 Reconstruction Error입니다.

Pre-trained 하여 Reconstruction Error로 학습시켜놓은 AE를 이렇게 부르고, Encoder만 GAN학습시 사용합니다. (L2 Loss)

2. Mode Regularizer

3. Manifold-Diffusion Training for Regularized GANs

AE와 GAN Loss를 한번에 조율하기 어려워서 2Stage로 분리 시킨것을 의미합니다.

첫번째로 위의 1번과 2번에 해당하는 Loss를 통해 GAN을 학습하고, 그다음 Adversarial Loss를 학습하겠다는것입니다.

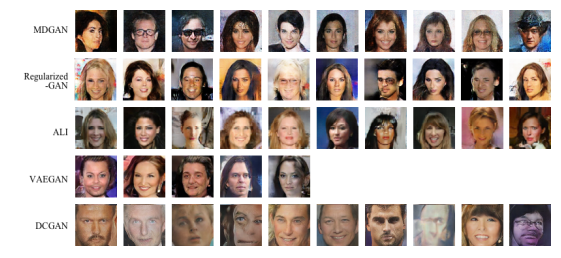

성능은 상기와 같이 다른 GAN들 대비 다양성과 Quality가 확보되었다 이런 내용입니다.

이 논문은 이제까지 GAN의 개발흐름상 중요했기에 리뷰해봤지만, 논문 저자가 자기마음대로 이름갖다붙혀서 도무지 읽히지가 않는논문입니다.

Vanilla GAN의 Adversarial Loss라고 부르는것을 Diffusion Step이라느니 마음대로 이름갖다 붙히고

또한, Autoencoder의 Reconstruction Error를 Geomietric metrics regularizer라며 어렵게 작명을해서 있어보이는척을합니다.

Results

GAN의 개발과정상 Diversity와 Mode Collapse를 막기위해 시도된 논문으로 읽어볼만하나,

저자가 본인만의 세계를 강조하는지 이미 Conventional 하게 있는 용어들도 자기마음대로 바꾸고 설명도 어렵게 있어보이게 적느라고 애쓰느라 이해하기 어려운 논문. 하지만 굉장히 별거 없는 논문.

댓글