논문 전문 : https://arxiv.org/abs/1906.03821

[출처] KDD '19: Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data MiningJuly 2019Pages 3009–3017https://doi.org/10.1145/3292500.3330680

※ The picture and content of this article are from the original paper.

This article is more of an intuitive understanding than academic analysis.

[논문 요약]

Time-Series Anomaly Detection Service at Microsoft

개인적으로 Citation수 대비 아쉬움이 많은 논문입니다.

이게 연구논문인지 본인들 Microsoft Azure 광고하는 CF인지도 분간 되지않을정도이기 때문입니다.

또한 SR(Spectral Residual)을 시계열데이터에 적용하는 이유에대해 논리적 인과성 또한 아주 부족합니다.

논문의 철자 그대로 옮기자면 "We belive that the visual saliency detection and time-series anomaly detection tasks are similar essentialy" 라고 합니다.

즉, 어떤 논리적 과정에 의해 Visual에서 많이쓰이는 SR을 쓰는것이 아닌, 시계열과 이미지 데이터가 Visual Salinecy Detection이 유사할것으로 "믿기때문에" 적용한다고 합니다.

물론 딥러닝 자체가 "해보니까 성능이 더좋아서"가 불문율이긴 하지만, 적어도 어떤식의 Approach를 하고있고 Layer별로 까보니 어떤식으로 학습하고있었고,... 그렇기에 Saliency Detection이 이미지 외의 분야에서도 효과적일것으로 추정되었다 라던가 이런 최소한의 스토리텔링은 있으면 좋았을것 같습니다.

Contents

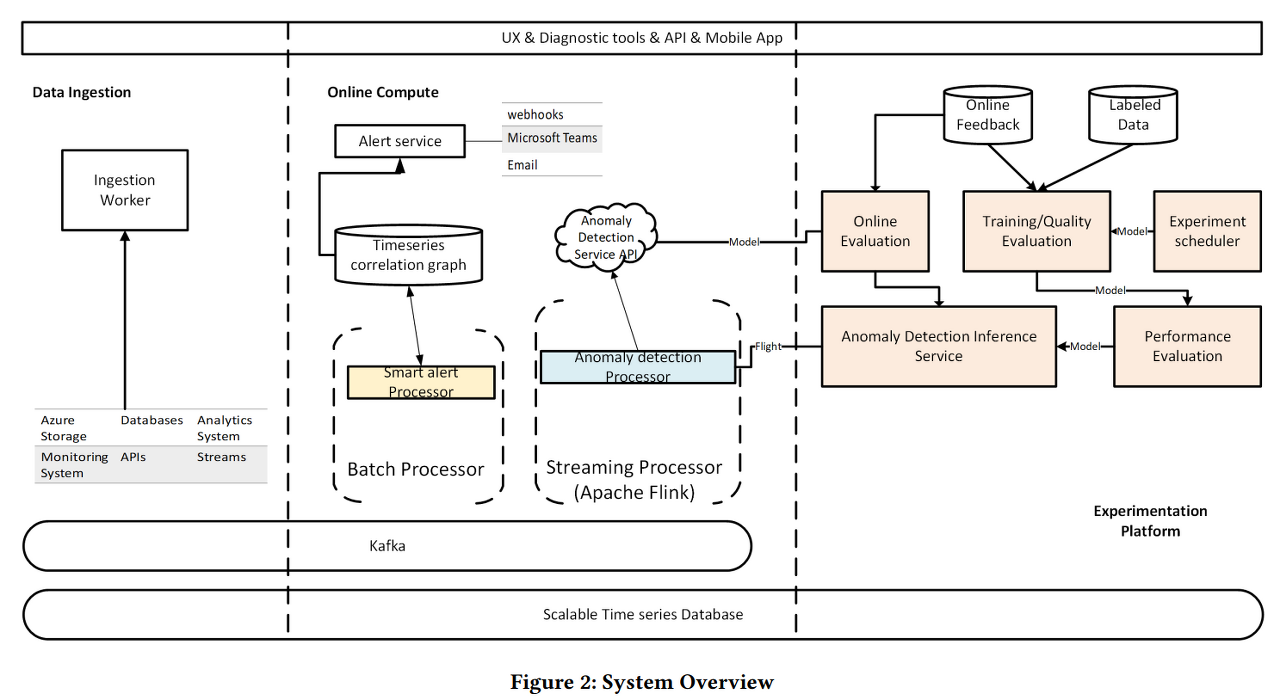

MS Azure를 사용해서 구현했으며, 거기에 어떤 모듈을 썼고... 본인들 Azure 서비스를 활용하면 이런게 다 구현되어있으니, 데이터를 이렇게 가져오면 되고 분당 백만개이상의 데이터를 windowing 처리할수있고...blah blah 되어있습니다. 대부분 연구로써는 가치가 없는말이구요

[4.1] Spectral Residual, [4.2] SR-CNN 이부분만 보셔도 무방합니다.

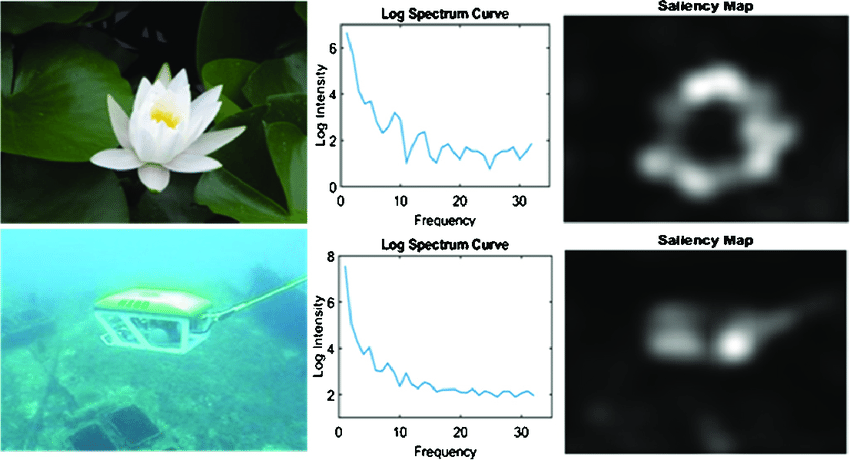

컨셉은 아주 간단합니다. Spectral Residual이라는 Vision에서 많이 쓰는 테크닉이 있는데, Time-Series 데이터를 FT(Fourier Transform)한 후, Spectral Residual을 적용하고 다시 IFT(Inverse Fourier Transform)해서 Saliency map을 보곘다는 내용입니다.

그러면 여기서 SR은 뭘까요??

데이터의 주파수 도메인에 대해 Ampltitude를 Log Scailing 하고 이것의 평균값을 구해 Log Scailing한 데이터에 빼고 다시 IFFT한것을 의미합니다. 수학적으론 하기와 같습니다.

수식으로도 충분히 간단하지만, 이것을 직관적으로 이해할때는 이렇게 생각하는것이 좋습니다.

"데이터의 주파수 분석을 통해 일정한 패턴이나 규칙을 가지는 부분을 제외하고 잔차(Residual)만 보겠다" 입니다.

즉, 일정한 패턴이나 규칙이 아닌 Anomaly Detection하기 좋도록 상대적으로 불규칙한 주파수의 데이터만 남겨서 보겠다는것입니다.

따라서, 다시돌아오면 Time-Series Input Data에 대해 주파수 도메인으로 Spectral Residual을 구하고 다시 시간 도메인으로 변경하면 상기와 같은 Saliency Map이 나오고 Anomaly한 부분에 대해서 저렇게 집중하여 볼수있게 된다는 것입니다.

그다음은 1D-CNN Layer붙여서 정상/비정상 판단하는 일반적인 딥러닝 모델을 붙인것입니다.

최종결과는 상기와 같은데, 당시기준 준수한 성능을 보여주고 있습니다.

Opinion

주파수 도메인, Wavelet Transform, ... 도메인 변경을 통한 데이터 해석-딥러닝은 누구든 할 수 있습니다.

다만, 이 논리적 흐름을 어떻게 잘 풀어서 논문의 독자들을 설득시키냐가 저는 상당히 중요하다고 생각하는데, SR-CNN의 성능과 별개로 이런 부분이 많이 아쉬웠습니다.

"We believe" , 본인들이 믿기때문에 해봤다. 이것 한줄로는 아무리 성능이 좋아도 독자들에게 논리적 당위성을 부여하기 어렵습니다. 물론, 딥러닝 자체가 귀납법적이긴 하지만 이건 좀 너무한게 아닌가라는 생각이 들었습니다.

더불어, Microsoft에서 나왔다는것을 굳이 논문제목부터 대서특필한게 상당히 의심스러웠는데, 논문 내용도 MS Azure라는 본인들 Cloud 시스템을 홍보하는것에 아주 많은 지면을 할애하고 있었습니다.

SR-CNN에 대해 정말 궁금한게 아니신분은 굳이 안읽어도 될 논문이라고 생각합니다.

참조

[1] KDD '19: Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery & Data MiningJuly 2019Pages 3009–3017https://doi.org/10.1145/3292500.3330680 https://doi.org/10.3390/a13030062

'AI > AI Paper review' 카테고리의 다른 글

| [NIPS-2020] Denoising Diffusin Probabilistic Models (0) | 2024.01.29 |

|---|---|

| [NIPS-2014] Generative Adversarial Nets (2) | 2024.01.25 |

| [AAAI-2019] TabNet : Attentive Interpetable Tabular Learning (2) | 2024.01.18 |

| [ICML-2021] Tabular Data:Deep Learning is Not All You Need (2) | 2024.01.11 |

| [NIPS-2017] Attention is all you need (0) | 2023.12.23 |

댓글